如何以DeepSeek为契机实现信息技术全面超美?

本文来自微信公众号:纯科学,作者:纯科学,题图来自:AI生成如果认真读完本文(90%以上普通读者都可以理解清楚),您不仅对人工智能,而且对整个信息技术的认知都可以达到这个领域全球一切博士生导师,甚至院士的层次。DeepSeek冲击波意味着全球信息技术即将实现基本架构革命,这场革命有两大特征:硬件体系从算力依赖型转向存储依赖型。整体架构从硬件依赖型转向编程依赖型。一、DeepSeek冲击波一个月前,整个美国军事圈在密集地讨论中国六代机。半个月前,整个媒体圈在讨论小红书上中美大对账。现在,整个全球科技圈又在密集地讨论DeepSeek。DeepSeek V3的发布日期是在2024年12月26日。在DeepSeek V3发布后短短的一个月左右,又连续两个大动作。2025年1月20日发布了DeepSeek R1,这是真正引爆全球的版本,其达到与OpenAI o1版本性能基本相同的程度,但训练成本仅为不到560万美元,只是o1的3%~5%。请注意,并不是说DeepSeek R1的技术性能远超OpenAI o1,而是在性能基本相同或略好的情况下,其训练成本、训练时间却呈现数量级的下降,这两者带来的结果都是颠覆性的。原因在于:训练成本极低的主要因素是对算力需求数量级的下降,这样一来,英伟达人工智能算力卡市场需求就会受到极大的冲击。训练时间从过去6个月下降到只有6天,这会使人工智能软件的迭代速度发生质的变化。6个月的训练时间,简直就是农业领域种子大田实验的周期长度了,一粒水稻种子从发芽、插秧、抽穗、收割的时间也不过如此。早熟型的水稻全部生长周期甚至也就3个月。任何软件都是需要不断迭代演进的,如果你的软件需要6个月才能完整地运行一次,而我的只要6天,那么你的软件做一次升级后要进行一下测试就得至少等6个月时间,而我的只要6天,那么即使我的软件一开始比你的差很多,要不了几个回合,我已经迭代10次了,你一次都还没迭代完,那你还怎么玩?就算你有天大的编程本事也没法和我竞争。而且DeepSeek还完全开源,这么一搞,全世界所有公司的大模型软件都不得不追随这个技术路线,尤其是技术理念,否则就是农业文明与工业文明相竞争了。DeepSeek在美国的苹果应用商店上下载量瞬间排名第一。2025年1月27日,Deepseek引发了美国纳斯达克震动,尤其是受冲击最大的英伟达,股价下跌16.97%,上一个交易日下跌3.12%。1月28日除夕,在美股重挫之后,DeepSeek又发布开源多模态模型Janus-Pro,其中70亿参数版本的Janus-Pro-7B模型在使用文本提示的图像生成排行榜中优于OpenAI的 DALL-E 3和Stability AI的Stable Diffusion。英伟达在两天内蒸发了7000多亿美元,跌去约五分之一的市值,27日一天跌去了约5900亿美元,创下美国历史上单日下跌幅度的历史纪录。也带动纳斯达克指数当日跳空暴跌3.07%。当然,这种短期的波动不一定完全具有长期意义,1月28日英伟达反弹了8.93%,29日再次下跌4.10%。但是,一个中国刚成立一年多、仅140人的小公司发布的产品,居然对整个美国纳斯达克科技股板块产生如此巨大的影响,这是历史上的第一次。因为整个美国科技界产生了恐慌,来自美国的一些特定的IP地址针对DeepSeek服务器发起了空前的恶意攻击。这种恶意攻击一直持续到现在,并且不断升级。特朗普也在个人账号上发出哀叹:请注意,特朗普个人账号发这个信息的合集分别是#美国优先#中国正杀死美国#AI#MAGA!!!如此震撼性的科技进展,也令整个中国社会沸腾。很多网友留言,希望我谈一下这个问题,很多媒体也向我约稿谈相关问题。对于如此专业的技术领域,一般媒体人,甚至一些专业人士都可能很难抓住要害。人们可能非常疑惑的一个问题是:为什么DeepSeek居然能在美国看起来如此领先的AI领域做出让人炫目的巨大改进?或者换个说法:为什么在看似美国领先的AI领域居然会存在如此巨大的改进空间?如果没有这种改进空间存在,即使你有天大的本事也无济于事。其实,这种巨大的改进潜力不仅不是什么奇怪的事情,而且是整个信息技术领域存在的极为普遍的情况,只不过是DeepSeek把这层窗户纸在全社会层面捅穿了而已。要清楚理解DeepSeek为什么能做到这一点,如果是专业的网友,可以直接去看以下这篇DeepSeek R1的论文,甚至直接去看开源的源代码。但对于绝大多数普通网友来说,如果完全陷到这些AI专业技术细节中去的话,肯定会头大,即使想尽办法进行科普,可能也还是很难理解。并且,即使专业的网友去直接看DeepSeek的论文,或者分析清楚DeepSeek的所有算法,也未必能完全理解为什么他可能做出这么大的改进。所以,本文将尽可能采用90%以上的网友都能听得懂的语言或科普知识,来让人们理解为什么美国式的信息技术会存在如此巨大的提升空间,并且是幻方量化的创始人梁文峰的团队成功做到了。事实上,这种潜在改进空间的存在是我穷其一生系统研究过,一直努力去进行改进,并且获得过不少成果的。所以,本文不仅是要让普通网友听明白,而且希望成为一篇信息技术领域的“讨美檄文”,借此机会号召所有专业的网友、政府机构相关人员和投资人看明白之后,从效率最优化角度发起一场系统的中国式信息技术革命,彻底颠覆美国式的信息架构和体系。我会在本文中列举出大量可以做出巨大改进的众多技术细节,但整个信息技术领域事实上可以改进的地方太多了,本文最后会给出初步的总体建议。二、认识世界的两种路径为了理解本文,我们不像一般人那样一上来就先钻到技术细节中去,而是脱离出来,先站在尽可能最高层面的、科学认识世界的两种基本路径的简要比较上。一个是经验的方法,另一个是理论的方法。这两种方法大家都是比较熟悉的。经验的方法是什么呢?用信息技术的语言来说,就是存储的历史知识依赖型的方法。当遇到一个新问题时,经验的方法可能不是去深入系统地理解问题本身,而是瞬间就能给出答案,它是直接对比问题与存储的历史知识,找出差别最小的一个,只要对存在差别的地方进行一下简单的处理,就能给出结果。所以,这种方法也是算力依赖度相对最小的。它本质上主要就是一种以经验知识查询和调用为主的算法。另一种方法是理论的方法,发展到极致就是科学的理论,牛顿力学用极简的四个定律的数学公式,就能描述世间所有的运动规律。麦克斯韦方程也只是几个极简的数学公式,就能描述所有电磁学的规律。理论的方法存储的知识量可以达到极小化,这是它的经济性体现。但是,当用这种理论的方法去解决实际问题时,要用这些数学公式进行大量的计算才能给出结果。所以,这种方法是算力依赖型的。以上两种方法是各有优劣的,并不能绝对说哪一个就更好。经验的方法算力依赖度最小,速度极快,但不一定完备、准确和深入,它也有可能搞不清因果关系。在计算机编程的时候可能通用性不是最好,要针对特定问题进行定制。理论的方法知识存储量最小,完备,因果关系清晰,精确,编程相对简单且通用性较强,但实际解决问题时需要精确获得所有边界条件,必须要大量的计算。现实生活中并不一定绝对分得清采用的是理论的方法还是经验的方法,很多都是两种方法的混合。例如很多经验公式看起来是一个理论,也的确可能存在一定的因果关系成分,但事实上是介于理论和经验之间的、不完备、也就是不完全清楚因果关系的数字统计结果。现在的人工智能很大程度上也是介于理论和经验之间的一种形态。如果举一些具体的例子来说明一下以上两种方法在信息技术中的体现,可能大家会更清晰一些。我在北邮上研究生期间的导师蔡学勋,他主要的一个贡献是最早实现了将原来只能用巨型机处理的气象卫星数据,转换成在个人电脑上进行处理。这个团队研究的成果之一是最先从卫星云图中发现了著名的1987年大兴安岭火灾,就是那个当年春晚小品节目中戏称为被费翔“冬天里的一把火”点燃的森林大火。要将卫星云图数据在算力很低的个人电脑上进行处理,遇到的最大挑战就是如何降低相关数据处理的算力需求。其中最大的运算量之一,就是将原始卫星云图数据投影到平面图上时,要进行数据的投影转换。它的原理并不复杂,也就是初中几何知识就能明白的,这里不去讨论,只是要说明这种投影转换每一个像素点处理都要进行三角函数的计算。三角函数的公式书写起来非常简单,可是要在计算机中进行计算的话就很麻烦。因为现代的电子计算机CPU事实上只能进行二进制的加法运算。所以,一切数学计算事实上都是把它们通过一定的算法转换成一系列加法运算的累加。一般的方法是先将任何数学函数展开成只含有加减乘除的幂级数展开式,然后再把其中的乘、除、减法转换成加法运算。上面就是一个初中生都可以理解的正弦函数的幂级数展开式案例。从纯理论上说,上面这个展开式的运算量是无限大的。但在不同的精度要求中,可以选择一个有限的最大n取值就可以了,以此进行可以保证一定精度的有限运算量。最大的n取值不同,当然运算量就不一样。但这样一转换,表面看起来一个很简单的数学函数,在计算机中需要进行的最基本二进制加法运算量就可能会扩张到成千上万次二进制加法运算。好在计算机过去按摩尔定律可以不断地翻倍增长,所以计算量大点用计算机来算就不是问题。这就是算力依赖型的解决思路。因为每一个像素点都要进行这样的处理,如果直接采用这种理论的算力依赖型的方法,在上个世纪80年代根本不可能在个人电脑上实现哪怕最简单的卫星图像数据的平面投影处理。所以解决的方法就是:先计算出一个实际应用中会用到的相对完整的三角函数表,并且存储起来。下面是一个常用的三角函数表。当用到哪个角度的三角函数计算时,直接到这个表里面查就可以了。这就把前面那种算力依赖型的方法运算量成千上万倍地降低了。如果要计算的角度不能直接查到,是在表中的两个角度之间,那就用相邻的两个表中的角度三角函数值进行简单的插值处理就可以得出结果了。这种方法就是存储的历史知识依赖型的方法。原来我们听说过中国两弹一星的科学家们是用算盘算出了原子弹的模型,很多人感觉不可思议。事实上,他们肯定不会用和计算机完全一样的算法来进行计算,肯定是会寻求算力依赖度最小的方法。主要也是基于各种已经算出来的函数表,诸如对数表、根号表、三角函数表等,在计算过程中尽可能依赖查表和插值处理,以此来尽最大可能地减少计算量,再用算盘来算,否则是不可能完成这个工作的。当年祖冲之用算盘算一个圆周率都花了几十年的时间,如果真的用算盘直接进行各种函数的计算,肯定是不可能在有限时间内算出原子弹相关模型的。初中生实用的根号表为什么我们要先谈这些最基本的科学认识方法论问题,因为只要理解了这些,就会很容易理解DeepSeek为什么如此高效。最基本的算法:以“先期预训练为基础”的纯强化学习(Pure Reinforcement Learning)算法。虽然单纯从强化学习算法本身来说可以从任何基础开始,但前面有一个预训练的基础还是非常重要的,简单点说就是已经训练过的内容就不要再重复训练了。就像已经计算过的三角函数就不要在每一个像素处理时重复计算。这就是节省大量算力的奥秘之一。强化学习算法主要以原来的训练结果为基础,只是不断调整新的处理结果与目标问题(强化学习算法本身的专业术语叫“环境”)之间的偏差(专业术语叫“奖励”)。我之所以尽量不用专业术语,而用一般人能理解的自然语言,不仅是理解起来会更为容易,还有更重要的一点是:很多专业术语事实上可能存在不一定完全合适的问题,很容易让人产生误解,后面会谈到。所以,简单地说,最新的DeepSeek版本训练成本只有560万美元是不完全准确的,DeepSeek过去投入的17亿不能说在最新的版本中没有任何体现。但在此基础上,完全新的训练真的可以做到新增的成本就非常低了。所以,说它最新的训练成本只有560万美元当然是有道理的。那其他很多大模型难道是每次新版本都是一次又一次重复去训练吗?客观地说,利用已经有的训练结果这种经验知识依赖的方法在其他大模型中也有体现,但总体上说他们的确是存在大量一遍又一遍进行重复训练的问题。这当然对算力的消耗就数量级地增大了。所以,信息技术虽然变化很快,但如果理解了最一般的科学认识方法,就会发现几乎没

本文来自微信公众号:纯科学,作者:纯科学,题图来自:AI生成

如果认真读完本文(90%以上普通读者都可以理解清楚),您不仅对人工智能,而且对整个信息技术的认知都可以达到这个领域全球一切博士生导师,甚至院士的层次。

DeepSeek冲击波意味着全球信息技术即将实现基本架构革命,这场革命有两大特征:

硬件体系从算力依赖型转向存储依赖型。

整体架构从硬件依赖型转向编程依赖型。

一、DeepSeek冲击波

一个月前,整个美国军事圈在密集地讨论中国六代机。

半个月前,整个媒体圈在讨论小红书上中美大对账。

现在,整个全球科技圈又在密集地讨论DeepSeek。

DeepSeek V3的发布日期是在2024年12月26日。在DeepSeek V3发布后短短的一个月左右,又连续两个大动作。2025年1月20日发布了DeepSeek R1,这是真正引爆全球的版本,其达到与OpenAI o1版本性能基本相同的程度,但训练成本仅为不到560万美元,只是o1的3%~5%。

请注意,并不是说DeepSeek R1的技术性能远超OpenAI o1,而是在性能基本相同或略好的情况下,其训练成本、训练时间却呈现数量级的下降,这两者带来的结果都是颠覆性的。原因在于:

训练成本极低的主要因素是对算力需求数量级的下降,这样一来,英伟达人工智能算力卡市场需求就会受到极大的冲击。

训练时间从过去6个月下降到只有6天,这会使人工智能软件的迭代速度发生质的变化。6个月的训练时间,简直就是农业领域种子大田实验的周期长度了,一粒水稻种子从发芽、插秧、抽穗、收割的时间也不过如此。早熟型的水稻全部生长周期甚至也就3个月。

任何软件都是需要不断迭代演进的,如果你的软件需要6个月才能完整地运行一次,而我的只要6天,那么你的软件做一次升级后要进行一下测试就得至少等6个月时间,而我的只要6天,那么即使我的软件一开始比你的差很多,要不了几个回合,我已经迭代10次了,你一次都还没迭代完,那你还怎么玩?就算你有天大的编程本事也没法和我竞争。而且DeepSeek还完全开源,这么一搞,全世界所有公司的大模型软件都不得不追随这个技术路线,尤其是技术理念,否则就是农业文明与工业文明相竞争了。

DeepSeek在美国的苹果应用商店上下载量瞬间排名第一。

2025年1月27日,Deepseek引发了美国纳斯达克震动,尤其是受冲击最大的英伟达,股价下跌16.97%,上一个交易日下跌3.12%。1月28日除夕,在美股重挫之后,DeepSeek又发布开源多模态模型Janus-Pro,其中70亿参数版本的Janus-Pro-7B模型在使用文本提示的图像生成排行榜中优于OpenAI的 DALL-E 3和Stability AI的Stable Diffusion。

英伟达在两天内蒸发了7000多亿美元,跌去约五分之一的市值,27日一天跌去了约5900亿美元,创下美国历史上单日下跌幅度的历史纪录。也带动纳斯达克指数当日跳空暴跌3.07%。当然,这种短期的波动不一定完全具有长期意义,1月28日英伟达反弹了8.93%,29日再次下跌4.10%。但是,一个中国刚成立一年多、仅140人的小公司发布的产品,居然对整个美国纳斯达克科技股板块产生如此巨大的影响,这是历史上的第一次。

因为整个美国科技界产生了恐慌,来自美国的一些特定的IP地址针对DeepSeek服务器发起了空前的恶意攻击。这种恶意攻击一直持续到现在,并且不断升级。

特朗普也在个人账号上发出哀叹:

请注意,特朗普个人账号发这个信息的合集分别是#美国优先#中国正杀死美国#AI#MAGA!!!

如此震撼性的科技进展,也令整个中国社会沸腾。很多网友留言,希望我谈一下这个问题,很多媒体也向我约稿谈相关问题。对于如此专业的技术领域,一般媒体人,甚至一些专业人士都可能很难抓住要害。

人们可能非常疑惑的一个问题是:为什么DeepSeek居然能在美国看起来如此领先的AI领域做出让人炫目的巨大改进?或者换个说法:为什么在看似美国领先的AI领域居然会存在如此巨大的改进空间?如果没有这种改进空间存在,即使你有天大的本事也无济于事。

其实,这种巨大的改进潜力不仅不是什么奇怪的事情,而且是整个信息技术领域存在的极为普遍的情况,只不过是DeepSeek把这层窗户纸在全社会层面捅穿了而已。要清楚理解DeepSeek为什么能做到这一点,如果是专业的网友,可以直接去看以下这篇DeepSeek R1的论文,甚至直接去看开源的源代码。

但对于绝大多数普通网友来说,如果完全陷到这些AI专业技术细节中去的话,肯定会头大,即使想尽办法进行科普,可能也还是很难理解。并且,即使专业的网友去直接看DeepSeek的论文,或者分析清楚DeepSeek的所有算法,也未必能完全理解为什么他可能做出这么大的改进。

所以,本文将尽可能采用90%以上的网友都能听得懂的语言或科普知识,来让人们理解为什么美国式的信息技术会存在如此巨大的提升空间,并且是幻方量化的创始人梁文峰的团队成功做到了。

事实上,这种潜在改进空间的存在是我穷其一生系统研究过,一直努力去进行改进,并且获得过不少成果的。所以,本文不仅是要让普通网友听明白,而且希望成为一篇信息技术领域的“讨美檄文”,借此机会号召所有专业的网友、政府机构相关人员和投资人看明白之后,从效率最优化角度发起一场系统的中国式信息技术革命,彻底颠覆美国式的信息架构和体系。

我会在本文中列举出大量可以做出巨大改进的众多技术细节,但整个信息技术领域事实上可以改进的地方太多了,本文最后会给出初步的总体建议。

二、认识世界的两种路径

为了理解本文,我们不像一般人那样一上来就先钻到技术细节中去,而是脱离出来,先站在尽可能最高层面的、科学认识世界的两种基本路径的简要比较上。一个是经验的方法,另一个是理论的方法。这两种方法大家都是比较熟悉的。

经验的方法是什么呢?用信息技术的语言来说,就是存储的历史知识依赖型的方法。当遇到一个新问题时,经验的方法可能不是去深入系统地理解问题本身,而是瞬间就能给出答案,它是直接对比问题与存储的历史知识,找出差别最小的一个,只要对存在差别的地方进行一下简单的处理,就能给出结果。所以,这种方法也是算力依赖度相对最小的。它本质上主要就是一种以经验知识查询和调用为主的算法。

另一种方法是理论的方法,发展到极致就是科学的理论,牛顿力学用极简的四个定律的数学公式,就能描述世间所有的运动规律。麦克斯韦方程也只是几个极简的数学公式,就能描述所有电磁学的规律。理论的方法存储的知识量可以达到极小化,这是它的经济性体现。但是,当用这种理论的方法去解决实际问题时,要用这些数学公式进行大量的计算才能给出结果。所以,这种方法是算力依赖型的。

以上两种方法是各有优劣的,并不能绝对说哪一个就更好。

经验的方法算力依赖度最小,速度极快,但不一定完备、准确和深入,它也有可能搞不清因果关系。在计算机编程的时候可能通用性不是最好,要针对特定问题进行定制。

理论的方法知识存储量最小,完备,因果关系清晰,精确,编程相对简单且通用性较强,但实际解决问题时需要精确获得所有边界条件,必须要大量的计算。

现实生活中并不一定绝对分得清采用的是理论的方法还是经验的方法,很多都是两种方法的混合。例如很多经验公式看起来是一个理论,也的确可能存在一定的因果关系成分,但事实上是介于理论和经验之间的、不完备、也就是不完全清楚因果关系的数字统计结果。

现在的人工智能很大程度上也是介于理论和经验之间的一种形态。

如果举一些具体的例子来说明一下以上两种方法在信息技术中的体现,可能大家会更清晰一些。我在北邮上研究生期间的导师蔡学勋,他主要的一个贡献是最早实现了将原来只能用巨型机处理的气象卫星数据,转换成在个人电脑上进行处理。

这个团队研究的成果之一是最先从卫星云图中发现了著名的1987年大兴安岭火灾,就是那个当年春晚小品节目中戏称为被费翔“冬天里的一把火”点燃的森林大火。要将卫星云图数据在算力很低的个人电脑上进行处理,遇到的最大挑战就是如何降低相关数据处理的算力需求。其中最大的运算量之一,就是将原始卫星云图数据投影到平面图上时,要进行数据的投影转换。它的原理并不复杂,也就是初中几何知识就能明白的,这里不去讨论,只是要说明这种投影转换每一个像素点处理都要进行三角函数的计算。

三角函数的公式书写起来非常简单,可是要在计算机中进行计算的话就很麻烦。因为现代的电子计算机CPU事实上只能进行二进制的加法运算。所以,一切数学计算事实上都是把它们通过一定的算法转换成一系列加法运算的累加。一般的方法是先将任何数学函数展开成只含有加减乘除的幂级数展开式,然后再把其中的乘、除、减法转换成加法运算。

上面就是一个初中生都可以理解的正弦函数的幂级数展开式案例。从纯理论上说,上面这个展开式的运算量是无限大的。但在不同的精度要求中,可以选择一个有限的最大n取值就可以了,以此进行可以保证一定精度的有限运算量。最大的n取值不同,当然运算量就不一样。

但这样一转换,表面看起来一个很简单的数学函数,在计算机中需要进行的最基本二进制加法运算量就可能会扩张到成千上万次二进制加法运算。好在计算机过去按摩尔定律可以不断地翻倍增长,所以计算量大点用计算机来算就不是问题。这就是算力依赖型的解决思路。

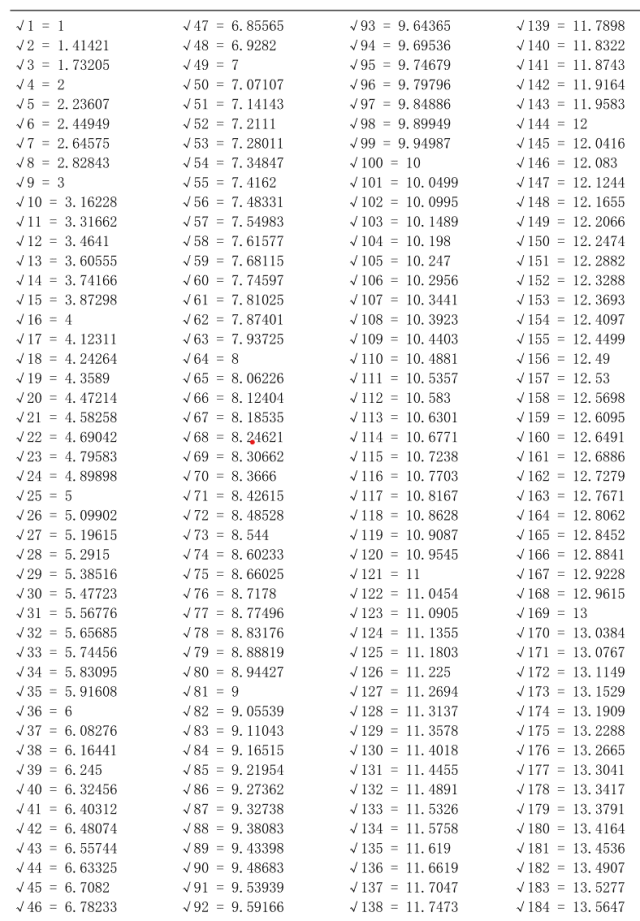

因为每一个像素点都要进行这样的处理,如果直接采用这种理论的算力依赖型的方法,在上个世纪80年代根本不可能在个人电脑上实现哪怕最简单的卫星图像数据的平面投影处理。所以解决的方法就是:先计算出一个实际应用中会用到的相对完整的三角函数表,并且存储起来。下面是一个常用的三角函数表。

当用到哪个角度的三角函数计算时,直接到这个表里面查就可以了。这就把前面那种算力依赖型的方法运算量成千上万倍地降低了。如果要计算的角度不能直接查到,是在表中的两个角度之间,那就用相邻的两个表中的角度三角函数值进行简单的插值处理就可以得出结果了。这种方法就是存储的历史知识依赖型的方法。

原来我们听说过中国两弹一星的科学家们是用算盘算出了原子弹的模型,很多人感觉不可思议。事实上,他们肯定不会用和计算机完全一样的算法来进行计算,肯定是会寻求算力依赖度最小的方法。主要也是基于各种已经算出来的函数表,诸如对数表、根号表、三角函数表等,在计算过程中尽可能依赖查表和插值处理,以此来尽最大可能地减少计算量,再用算盘来算,否则是不可能完成这个工作的。

当年祖冲之用算盘算一个圆周率都花了几十年的时间,如果真的用算盘直接进行各种函数的计算,肯定是不可能在有限时间内算出原子弹相关模型的。

初中生实用的根号表

为什么我们要先谈这些最基本的科学认识方法论问题,因为只要理解了这些,就会很容易理解DeepSeek为什么如此高效。最基本的算法:以“先期预训练为基础”的纯强化学习(Pure Reinforcement Learning)算法。

虽然单纯从强化学习算法本身来说可以从任何基础开始,但前面有一个预训练的基础还是非常重要的,简单点说就是已经训练过的内容就不要再重复训练了。就像已经计算过的三角函数就不要在每一个像素处理时重复计算。这就是节省大量算力的奥秘之一。强化学习算法主要以原来的训练结果为基础,只是不断调整新的处理结果与目标问题(强化学习算法本身的专业术语叫“环境”)之间的偏差(专业术语叫“奖励”)。

我之所以尽量不用专业术语,而用一般人能理解的自然语言,不仅是理解起来会更为容易,还有更重要的一点是:很多专业术语事实上可能存在不一定完全合适的问题,很容易让人产生误解,后面会谈到。

所以,简单地说,最新的DeepSeek版本训练成本只有560万美元是不完全准确的,DeepSeek过去投入的17亿不能说在最新的版本中没有任何体现。但在此基础上,完全新的训练真的可以做到新增的成本就非常低了。所以,说它最新的训练成本只有560万美元当然是有道理的。

那其他很多大模型难道是每次新版本都是一次又一次重复去训练吗?客观地说,利用已经有的训练结果这种经验知识依赖的方法在其他大模型中也有体现,但总体上说他们的确是存在大量一遍又一遍进行重复训练的问题。这当然对算力的消耗就数量级地增大了。

所以,信息技术虽然变化很快,但如果理解了最一般的科学认识方法,就会发现几乎没什么新技术。一切所谓的创新技术都是原来已经有的技术原理在新的技术条件下的再现,别被那些所谓的“尖端技术”包装唬住了。中国是如此,美国同样是如此。

三、提升信息处理效率的最一般方法

1. 去掉冗余

无论是理论的还是经验的方法,要提升信息处理效率,其最基本的原则其实是一样的,就是尽可能减少“重复”——或者用信息技术的语言叫减少“冗余”。

如果是在存储中,已经存了一份信息,完全相同的信息不用再重复地存储,这就是存储信息的压缩。一切文本、图像、视频的压缩技术和存储器的压缩技术,都是通过各种途径减少重复的信息,这就可以节省存储空间。

如果是已经计算过一遍的模型,就不要再重复地进行计算了,这就是算法上运算量的压缩。

2. 适当降低精度

精度要求越高,一般来说对算力的需求就更大。尤其是一些关系不大的细节,简单地去掉,就可以节省大量的算力以及存储量。

例如,在图像处理中,因为人对颜色的细节敏感度远远低于亮度,所以一般是在相邻的四个像素的色度信息中,只保留一个就可以了。这样本来是每个像素一个亮度两个色度共三个信息,四个像素3*4=12个信息,直接可以去掉6个(三个像素中的两个色度信息),这样就可以直接将图像信息量减少一半。这种图像格式就叫4:2:0,原始图像格式是4:4:4。在图像的有损压缩中,也是将部分不重要的细节信息(信息量会更大)直接丢掉,从而极大地减少存储所需的信息量。

在人工智能中,也存在这种适当降低精度的方法,叫“量化”。我个人认为这个术语起的名字很不好,尤其一般人可能不太好理解。所以,如果你是普通人,看不懂一些专业术语,不要自卑,可能不是你理解力不行,而是这个术语名字起得真是太差了,这种情况其实是非常普遍的。

量化这个词用的场合太多,大多都不太合适。例如DeepSeek这家公司最初所从事的行业就叫“量化交易”。这个“量化交易”中的量化一词起的名字也不是太好。最好的词是普通人第一眼看到的理解就是准确的,并且与术语本身字面的意义最好一致。所谓“量化”是把原来不是“数量的”变化成“数量的”。例如模数转换(A/D)电路中把原来的模拟量转化成数字量,这个过程就叫“量化”。这也是“量化”这个专业术语最原始的正宗含义,其他领域的“量化”叫法都是借用的。我就是在大学里学电路专业出身的。所以这种术语唬别人可以,想唬住我行不通。

人工智能中所谓的“量化”是简单地降低数据的精度,例如把4个字节的浮点数据减少成2个字节的浮点数据,存储量就简单地降低了一半。原来的数据就是数量化的,只是精度减少了,这怎么能称为“量化”呢?它是“粗略化”“低精度化”。但如果这么按真实含义来起名字,就显得自己这个技术很Low。所以就起个“量化”这种听起来高大上,又让人云里雾里的名字。

量化交易中的“量化”这个词也是不太合适的。因为原来的投资交易也是以大量数学模型和数据为基础的。量化交易的关键,是把选股和买卖决策判断,通过设定相应的交易策略后,交给计算机程序自动实现了。所以,称“计算机自动化交易”可能更容易理解一些。当然,也可能最初搞这个交易的人就是不希望普通人搞明白,才起这种听起来高大上又含糊不清的术语。既然最初的人起了名字,后面的人只好延续这个术语,好显得自己是专业的。所以,不要以为你能讲专业术语就能唬住人。

与量化交易相对应的还有“高频交易”。中国证监会2024年5月11日发布的《证券市场程序化交易管理规定(试行)》第二十一条的规定,高频交易是指具备以下特征的程序化交易:(一)短时间内申报、撤单的笔数、频率较高;(二)日内申报、撤单的笔数较高;(三)证券交易所认定的其他特征。

其实,这些定义都没抓住要害,也是这个名称中的“高频”这个用词不完全恰当造成的。这种交易的关键要害是利用比一般交易所更低延时的通讯技术手段,因为其延时更低,这样就可以在一个极短的时间内,相当于提前可以获知股价的变动,从而提前下单买进和卖出,这就铁定可以赚钱了,虽然一次赚得不一定很多。

因此,这种交易的本质是“短时提前交易”,而绝对频度不一定很高。当然,因为其短时,股票的差价就大不到哪里去,为了获得更多收益,它一般的确会进行更多次的交易。多次可能是“高频”,也可能不一定是“高频”,而只是在相当长的一个时间内“多次”,频度倒不一定很高。但无论如何,如果你不具备低时延的光纤通讯系统作支撑,比他人提前获取股票价格和买卖双方的下单信息,单纯的程序化高频只会死得很惨。

回到本节主题的降低精度减少硬件需求的方法,需要注意的是,简单降低精度也有可能导致最终效果不一定满足要求。所以这里面也是有技巧的。

3. 适当简化、降低问题复杂度

如果要计算的参数越多,当然计算量就越大。如果对模型进行适当地简化,减少参数和复杂度,计算量一般就会相应地下降。100亿参数模型进行数据训练,与1000亿参数相比,简单地来评估,在其他方面都一样的情况下,计算量就会下降一到两个数量级。但复杂度或参数减少了,可能其性能表现等也会有所降低。如果能够很好地选择参数和调整好各项系数,有可能做到性能表现上差异极小。

这种方法在人工智能中叫“蒸馏”(Distillation)。我同样认为这个术语很不好甚至非常糟糕。因为它显然是引用化学中的蒸馏法这个术语。但化学中的蒸馏法是什么呢?

比如我们喝的蒸馏水,是通过把含有极少量杂质的水加热成蒸汽,然后在另一个冷凝器重新变成水。从中可知蒸馏法的特点:目的是去除水中极少量的杂质,因此,蒸馏以后的水与之前的可能体积和重量变化都极小。一公斤含杂质的水,蒸馏以后可能还是非常接近一公斤的纯净的水。

但人工智能中的蒸馏法想表达的过程,与化学中的蒸馏法显然有比较大的差异。事实上它与“提纯”更为接近:

提纯后体积重量一般会极大地变小。

提纯后的物质可能还是有极少量杂质。

被提纯过程丢弃的部分也可能含有少量未提纯出来的有效物质。

或者,也可以叫“裁减”等更准确并更容易理解的术语表达。

但是,如果采用这些更通俗并更准确和容易理解的术语的话,那就显不出是尖端技术了。所以,叫“蒸馏”这种有点莫名其妙的术语,就会显得比较牛掰。在技术甚至很多科学领域,其实都存在类似的情况。我过去曾专门写文章讨论过分子生物学领域起的学术名字非常糟糕的大量案例。一旦搞清楚这些,读者理解起来就不会那么困难了。

所以,本文为什么一开始就强调要站在更高的层面来看问题,因为只有这样“看扁”那些专业术语,你才能很容易地真正理解它们的准确含义。

OpenAI现在指责DeepSeek是对其对应版本软件的蒸馏。事实是否如此我们不去评论,但就算存在相应的过程又能怎么的?这本身就是人工智能中通用的合理方法。况且,DeepSeek也未必只针对OpenAI为蓝本去进行优化。还可以有更多自我优化的过程。他也未必只是从OpenAI模型的参数中简化出来的。

你可以去指责DeepSeek抄袭,但我可以告诉你,这个世界上几乎就没有几个技术是绝对原创的。可以说,美国几乎所有的技术全是在新的基础条件下,对完全相同技术原理的不同实现和综合,只不过给了个不同的技术概念名称,就以为是全新的顶尖科技了。

整个现代的计算技术就是对中国算盘的抄袭和新技术条件下的细节改变,所有信息存储技术全都是对中国造纸术在新技术条件下的发展,所有现代的数字编码技术全是对周易八卦的抄袭和新技术条件下的发展。

有人指责鸿蒙系统中有Android的代码,那你以为Android是谷歌原创的吗?不是。并且,创立Android的安迪·鲁宾在之前有在苹果和微软公司的工作经历。Android是在Linux、苹果、微软公司的大量技术资源基础上发展起来的。谷歌不仅不是Android的原创者,而且它是把安迪·鲁宾与其他人在2003年10月创立的Android公司,在2005年通过收购并入谷歌的。

微软最初的DOS系统,就是抄袭基尔·代尔的CP/M操作系统,而且还不是微软自己抄袭,是直接买的另一家抄袭的小公司产品,连其中基尔·代尔最初的语法错误“1 file(s) copied”都原封不动地抄袭过来,一直到微软的DOS操作系统被视窗系统完全替代了,这个语法错误都没完全改过来。

只要法律上不违反专利,“抄袭”换个名字就叫“学习”。

所以,那些指责DeepSeek抄袭的人早点闭嘴吧,这唯一证明的只是你们压根就不是这个圈子里的人。除了中国的算盘、造纸和周易是真正0到1的原创技术以外,此后的信息技术发展从始至终就全都是“抄袭”的。

四、DeepSeek的特色技术

1. 三个重要的特色技术

要理解DeepSeek为什么效率这么高,仅仅说它采用了蒸馏技术是差太远的。需要认识到它的确有很多自己特色性的技术。从这些特色性的技术中可以看到,他们的出发点都是尽最大努力去减少人工智能中的各项成本。例如:

不依赖于对用于训练的数据进行人工打标签。

混合专家架构(Mixture of Experts:MoE)。

多头潜在注意力(Multi-Head Latent Attention,MLA)。

2. 打标签是怎么回事

要理解DeepSeek不依赖于人工打标签,首先得理解打标签是怎么回事。人工智能软件为什么能理解人类的文本和图像等数据?这个如果不理解对数据打标签的话可能会感觉很神奇,但理解了这个后可能就没有什么神秘感了。如果从一开始就是把互联网上的数据直接输入人工智能软件里,要让它准确理解是极为困难的。

所以,原始的数据并不是直接输给软件,而是先由人去判断并打上标签。简单来说,比如“美国”和“美图”这两个词,前一个要理解成一个国家“美国”,后一个要理解成“美丽的图片”简称。这类理解是首先由人工智能的工程师制定好一些规则,然后交由专门进行打标签的人去干的活。所以,别以为大模型的人工智能真的那么神奇,真的有智能,其实还是人类智能的计算机化。

但是,这么干的话有一个问题,就是人工打标签是一个成本很高,效率也比较低,而且工作量很大的事情。美国Scale AI公司就是专业给其他大模型公司做人工打标签的工作的。所以现在这个公司的创始人亚历山大·王就马上跑出来公开指责DeepSeek。原因很简单,你DeepSeek要是这么搞,会让Scale AI压力山大,没活干了。

那DeepSeek为什么可以不依赖于人工打标签呢?最初的模型还是需要人工打标签的,但是我们前面说了,提升效率的方法就是去掉冗余——已经打过标签的应该就不用重复再打了呀!另外,采用强化学习的方法,事实上不是在事先对数据进行人工理解的判断并打标签,而是可以在模型运行之后做出人工的判断来调整之前训练的数据,也起到与人工打标签类似的作用。如果整体上是在之前已经采用人工打标签的方法训练过的基础数据之上进行强化学习,就基本不需要再人工打标签了。

理解了我们前面铺垫的基础方法论层面的知识,这个奥秘是不是就可以一语道破了。

3. 混合专家架构MoE

我在本文中尽量不深入技术细节,尤其不深入DeepSeek具体是怎么实现的,原因在于,对绝大多数人来说,不需要去了解那些细节。对其他专业的技术人员来说,如果你理解了最基本的原理,你也可以用不同的技术路线去实现,甚至获得更好的技术实现。对DeepSeek来说,他们本身就在天天修改代码进行各种改进,所以其他人太过于深入地追实现的细节永远也追不上的。

我个人事实上从了解通用人工智能技术的一开始就很推崇混合专家模型这个技术路线。那还是十多年前,连OpenAI都还没有成立的时候,我就作为投资人在硅谷接触到一些当时顶尖的通用人工智能创业公司。我当时就对“通用人工智能”这个概念非常有疑问,或者说非常不赞同。各种专业的人工智能技术早就有了,为什么不通过整合不同专家系统来实现通用的人工智能呢?当时那些创业者的技术团队给我的回复是:这种思路业界不是没人提,但要提前进行数据的专业分类会非常麻烦,而且不同人的理解会不一样。

“通用人工智能”这个概念本身也不是太合适的,误导了社会大众。事实上,这个技术最初的Transformer最大贡献是实现了一种比较通用的生成式人工智能算法。所以重点在“生成式”,而不是“通用”。

目前人工智能热点向混合专家架构转化,可以说与我最初的判断是相符合的。当年的神经网络技术也是有很大通用性的啊?为什么不说神经网络和深度学习算法也是通用人工智能呢?当然,中间走一个大而全的通用人工智能过程也是有意义的,就是先摸索出一些新的模式出来。而且,不同专家模型的形成也是在这个过程中自然形成,这样就不用提前去做专业数据分类的工作。这种提前进行的分类可能也不一定合适。

人类也是分成各个领域专家的,要解决通用的问题也是不同专家合在一起来实现。人工智能当然也会走向这个模式。

混合专家架构的好处是什么呢?这个需要结合前面所说的强化学习。因为已经训练出来的数据需要在新的与环境的交流中不断地进化。设想一下,我们就以量化这个词为例,因为它在不同的专业领域含义是不一样的。

如果不加任何区别,它就会在不同专业领域跳来跳去,差别较大。如果出现一个新的领域采用量化这个词,产生的差异就更大了。这就会给已经训练好的人工智能数据产生比较大的干扰。但是,如果分成各个不同的专业领域,那么它们相互之间就不会产生干扰了。新的环境变化越小,对模型产生的干扰就越小,也越容易趋于稳定、计算量也越小。

通用人工智能的技术路线,所有的数据与其他数据都可能有相关性(被称为“稠密模型”),这个计算量就太庞大了。但通过混合专家系统的专业分类(被称为“稀疏模型”),大多数的相关性计算可以只与自己专家模型内的数据进行,这就极大地降低了总体的计算量。很多会议为什么要分组讨论,其实也是同样的原理,没多大关系的就不要在一起浪费时间。

多个专业模型合在一起,表现得像是一个什么都懂的通用人工智能,就需要在一开始先分清楚新的输入属于哪个专家模型的,从而好交给它来处理。这就需要一个“门控”的判断机制。但凡是学过编程的人是不是马上会想起Switch(英文含义是转换、开关等)这个几乎所有编程语言都常用的语句?它就是一个门控机制。最简化的只有两个选择的门控编程语句是if。

所以,真正的技术原理其实都是差不多的,只是不同条件下不同的实现而已。Switch这个语句就是会提供一个判断的条件,当判断出不同结果时,就交给不同条件下的子程序去处理。它就像是一个大公司的前台,来的客人说明自己的来意,前台就会判断他要找的是哪个部门的人,然后就会给你引导到这个部门去具体处理。

混合专家架构MoE可以看成是一个高度放大版的Switch编程语句。

4. 多头潜在注意力MLA

我同样再强调一下别被表面深奥的技术概念搞晕头了。简单来说,当很多人去用人工智能软件如DeepSeek或豆包等进行查询的时候,输入的查询要变成计算机的语言,它叫键(Key)和相应的值(Value)。

记住我们前面说的基本原理,你马上就可以想到,那么多查询肯定有大量重复的。如果所有查询全是独立地在内存中存储,当然会占用大量宝贵的内存。那么,如果把那些重复的查询整合在一起,实现压缩,那内存占用是不是就非常小了?MLA其实就这么简单。实际进行查询的时候解压缩出来就和原来是一样的处理过程了。

这个就如同我们在网上看直播的时候,视频最初是经过压缩后才在网上传的,等传到用户处再解压缩后重现出来。

如果有人直接将原始视频在网上传,当然占用的资源就大多了。美国的人工智能就是这么干的。所以不是DeepSeek效率太高,而是美国的技术路线实在是太 Low了。

五、为什么美国的信息技术会存在这么大的改进空间?

美国引领了整个信息技术的进程。这使得美国建立的信息架构成了全世界的标准。其他国家的技术人员往往是不问为什么标准会这么建立,直接拿过来就用。即使发现一些看似很不合理的地方,也会认为这里面肯定有什么我们不知道的原因才如此,人家美国肯定都想清楚了。事实上完全不是这样的。

其实也可以说DeepSeek采用的技术没有任何是真正原创,美国全都有。信息技术实在是太多了,实现相同目标的技术路径和方案可以有非常非常多的选择。选择不同的方案和技术路线不同,可能会体现出不同的文化。

1. 各种资源的成本平衡问题

第一个问题是:软件的实现涉及很多方面资源成本的平衡:

计算能力成本。

存储能力成本。

网络带宽成本。

编程的人工成本。

其他。

实际的产品实现中,需要根据不同资源的成本差异,设计不同的实现方案。

(1) 如果计算能力获得很容易,存储成本很高,那么在算法上就会倾向于算力依赖型,这样更为经济。

(2) 反之,如果存储成本很低,计算成本很高,就可以倾向于采用算力极小化,历史经验知识依赖型算法。

(3) 如果编程的人工成本和管理成本很高,计算和存储能力的获得都很容易且成本较低,就会倾向于用最简单的编程算法去实现,而不用太关注产品计算和存储的成本消耗和效率。这就是一种硬件依赖型的算法。

(4) 如果硬件成本相对极高,就得通过更为复杂的编程去尽可能节省计算和存储的硬件资源。

(5) 如果网络带宽成本很高,就会追求需要传输的信息更高压缩率。

所以,如果没有以上各个方面成本的综合平衡,是不能简单地说哪种算法或策略更好的。

但是,美国在引领信息技术发展的过程中,逐步形成了他们自己特定的文化。因为芯片的摩尔定律,计算和存储能力是可以很容易获得并迅速增长的,而美国的人工比较贵。所以,美国就形成不太关注计算和存储效率的最优化,而主要关注编程的方便性、简洁性、可读性等。这个虽然不那么绝对,但总体上是这样。

20世纪90年代初,我在北邮上研究生期间有过很深的体会,我的课题是要做一个叫作潮涌填充的算法软件。这个是被用作诸如卫星云图中任意不规则的如湖泊等水面确定以及面积计算。所谓潮涌填充算法是先由软件操作人员从一个很明显是湖面上的一点开始,然后计算机自己从这个像素点开始,通过判断与其相邻的像素是否有相同的颜色。如果是相同的,就打上标签,如果不是,就放弃这个方向的继续判断。

这样到最后会把所有相邻的(相互连通的)湖面像素全都找出来。这种潮涌填充最原始的算法是非常简单的,就是一个像素点的处理是判断其上、下、左、右四个像素,如果是相同的,就以这个新的像素为基础进行相同的处理过程。这种自己调用自己的方法被称为“递归”方法。

这种最简单像素判断的“递归”算法带来的一个问题是,它不去记住已经判断过的像素,每次递归调用都是上下左右四个像素都进行判断,这样,每个湖面的像素点很可能会被重复判断四次。这种算法就是纯粹算力依赖型的。我当时就建立了一种“有向潮涌填充算法”,可以使湖面的每个像素点只要被判断一次就可以了。

其原理也就是历史经验知识依赖型的方法,把已经判断过的像素记住(实际实现中是采用记信相同颜色的线段两个端点),这样就可以使所有湖面的像素基本上作一次判断就可以了,这就使计算效率达到了最理想的程度。实现这个软件后,我与美国当时最先进的同类软件进行了对比测试,的确效率成倍提高,与理论分析是一致的,达到了当时世界上最高的计算效率。

这个给我非常大的触动——啊,我怎么这么容易就搞出一个世界第一呢?而且改进的幅度居然这么大?在此过程中,我对软件系统的效率问题专门作过大量的研究。例如,将最常用到的变量(如计数器变量等)设置成CPU中的寄存器变量的话,因为寄存器访问速度最快,所以即使其他部分不作变动,软件所需要的计算时间也会显著缩短。

研究生毕业后,我作为王码电脑惠州有限公司的总工程师,进行过大量电脑硬件和软件开发工作。在此期间我刻意研究过软件系统的效率问题。例如,我曾将一个数据库系统整个软件和数据通过当时的一个“虚拟硬盘”的软件全部装进内存里,就这么一个简单的措施,居然让运算效率提升了一个数量级。

这些研究经历使我明白一个道理:美国因为是CPU芯片等计算能力生产的核心,它的产品研发理念是不缺计算能力,但软件编程的工程师很贵。所以采用编程尽可能简单、好管理,而不用太关注计算效率的信息技术文化。

2. 商业因素

形成这种文化还有第二个方面的商业原因。因为CPU是INTEL等公司生产的,他们严格按照摩尔定律不断地成倍升级芯片性能。如果抛弃计算依赖型的算法,过多地提升计算效率,新的CPU就不会有那么强烈的需求了。在整个信息技术的硬件产品中,掌握CPU的公司无疑具有整个信息技术架构最基本的标准控制能力。所以,在所有硬件中,掌握CPU的公司相比于存储产品的公司,拥有更大的话语权。外设类的公司话语权就更弱了。

所谓的WINTEL联盟,就是这两家公司形成一种默契,INTEL会说服微软根本不用过于关注软件的计算效率,这个问题交给INTEL来解决就可以了。微软也乐得将更多精力关注于编程的简单性和用户界面的更加友好。因此,这种文化长期演变下来,就会在计算效率上形成巨大的改进空间。

这种计算效率非常低下的改进空间,在人工智能时代也延续到英伟达与OpenAI等形成的软硬件体系上。

事实上,所有那些技术改进,提升计算效率的方法美国人都知道,甚至大多数都是他们最先提出来的。但因为这种文化的形成,他们甚至会因为商业的人为因素,而不会去充分利用这些技术,在一定条件下还会人为地故意降低硬件的使用效率,甚至会使这种效率降低到令人感到匪夷所思的荒唐地步,仅此而已。

这就是为什么DeepSeek可以将人工智能的计算效率提升这么大的技术可能性所在。

六、中国式的“编程依赖型、硬件资源极小化”文化

1. 中国历史形成的硬件资源极小化的文化

中国共产党从最初创立之始,就是在极度缺乏各种硬件资源的条件下发展起来的。所以,中国早就形成了“编程依赖型的、硬件资源极小化”的文化。这种文化体现在非常多的领域,例如抗美援朝战场上,志愿军能将武器装备的资源利用效率,通过各种途径发挥到极致,利用的是“人的主观能动性”。但美国却是一种简单投入更多硬件资源的所谓“范弗里特弹药量”文化。

硬件资源极小化,对应的就是硬件资源利用率的极大化。

在信息技术领域,中国并不是从一开始就形成硬件资源极小化文化的。因为美国最初掌握了几乎所有硬件,给其他人留下的主要是应用层的编程。如何去调用最底层硬件资源的算法,是通过各种“函数库”、高级编程语言等给封装起来的。单纯应用层的编程人员只知道程序在干什么,一般并不知道它具体在CPU、寄存器、内存、缓存、硬盘、总线中是怎么存储、传输和计算的。在这种情况下就很难去提升硬件效率。

但是,随着中国产业链不断地深入到底层的硬件,中国的工程师们也逐步了解了最底层的技术细节。要想充分地发挥硬件的能力,就需要在编程时采用更为底层的编程方法。采用汇编语言一般来说就很容易实现比高级语言的硬件效率更高。尤其中国公司做了更多软硬件集成的系统工作,对充分发挥硬件能力的技术积累有很多的条件和机会。

DeepSeek主要采用的编程语言是PTX(Parallel Thread Execution)语言,接近于比较底层的汇编语言,它可以更好地在大算力需求的程序上直接调度硬件资源,从而实现更高的硬件效率。而一般常用的人工智能高级语言Python,主要被用于模型的建构、训练和部署等硬件执行效率不是那么高的部分。

因此,DeepSeek就是采用的抗美援朝战场上志愿军的打法,用远低于对手的硬件需求,超高的硬件使用效率,从而能将对手杀得丢盔卸甲。

2. 后摩尔定律时代的大趋势

现在社会很多对人工智能的观念理解都是错误的。例如认为发展人工智能一定要很大的电力消耗。如果真是这样的话,人工智能是发展不下去的。

在过去摩尔定律正常有效的时代,用相同的电力消耗可以持续获得成倍增加的算力。但是现在,随着摩尔定律越来越失效,要获得成倍增加的算力,就得接近于成倍增加电力消耗。如果还是延续过去摩尔定律有效时代的算力依赖型编程文化,即使中国这样电力发展非常好的国家也是承受不了的。

因此,算力提升的困难并不仅仅是中国会遇到,美国也会遇到的。只是中国因为美国对高端芯片的制裁而提前认清了算力不足将在未来成为长期的客观事实。也造成了中国工程师和企业提前转向算力极小化的策略。

因此,这一次DeepSeek的冲击并不仅仅是一次特定产品技术的冲击,而是一次两种信息技术发展文化和理念的大对撞。

七、中国的战略选择

2024年8月份,DeepSeek的部分投资人和一些人工智能相关领域的专业人士,邀请我和华为负责战略的一位朋友一起进行非正式的餐叙,讨论人工智能大模型的相关问题。虽然说是非正式的讨论,但作为投资人当然还是想寻求大模型,尤其是DeepSeek的大模型是否可以找到某种商业模式赚钱。

席间刚开始我是不太敢说话的,因为我对人工智能的观点向来比较保守。华为的朋友一直很坦率地持否定的态度,认为很难有什么成功的商业模式。我是在华为的朋友说了很多以后才敢说出自己基本认同他的个人想法的。但是,这个餐叙谈得大家都很郁闷和心情沉重,到后来我又不敢再说话了。

DeepSeek的投资人甚至有些直白地表达出:汪老师,别再这么说了,如果再这么讲下去,那就等同于完全否定掉这个项目了。席间我也试图积极地提出各种商业模式的可能性,例如模仿Scale AI的打标签外包等,也提到既然没有商业效益,不如完全开源获得社会效益。

今天,DeepSeek的社会效益的确达到了那天我们曾设想和讨论过的所有局面。

这也是幻方量化这家公司可以干成这件事的原因所在,因为他不完全是指望这个挣钱的。

我不能说那次非正式讨论对今天的DeepSeek开源起到什么作用,但很欣慰在DeepSeek今天被公众知道之前,就有机会深入研究过这家公司。

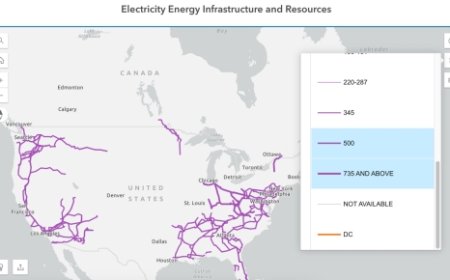

从中国目前特定阶段的情况来看,我们已经突破了随机存储(合肥长鑫等)与闪存(长江存储等)硬件技术。从芯片技术本身来说,存储的集成度天然地就高于计算,因为在随机存储器芯片中,存一个比特信息只需要一个晶体管;在闪存中,一个晶体管甚至可以存2个(MLC闪存芯片)、3个(TLC闪存芯片)、4个(QLC闪存芯片)比特的信息。而在CPU中,一个比特的信息单元至少需要四个晶体管实现。在人工智能算力的芯片领域,中国目前还稍微落后。所以:

在整个硬件的成本平衡中,中国应当采用算力极小化,存储依赖型的策略。以往的计算体系,尤其在PC时代形成的计算体系架构中,是以“内存稀缺”为前提建立的。例如最初设计的“虚拟内存”技术,就是为解决内存非常稀缺的问题而提出的。这种情况在内存成本已经大幅度降低,并且可以实现海量内存以后依然延续。

我曾在1998年就提出过“海量内存计算机”的概念,并且相关文章作为专题分三期发表在当时的《计算机世界报》上。十年之后SAP公司才提出“内存计算”的概念,但“内存计算”这个概念是不准确的,因为所有计算都需要内存,只有海量内存才是本质所在。因此,建立“计算稀缺,海量内存”为前提的信息技术架构,是未来必然的方向。

在整体成本的平衡中,中国则应当采用编程依赖型,硬件资源极小化的策略。我在业界最先提出的SDN(软件定义网络),在数码视讯工作时提出的EMR架构,都是硬件资源需求最小化的解决思路。当时在荷兰阿姆斯特丹参加IBC展会时,中国广电系统的领导看了EMR之后兴奋地说:太好了,这个和国外相比差距还剩多少啊。我回答说:国外公司和我们相比嘛,那差距还是有的。

不好意思,这个体系架构的创始人就在你眼前。他们听后:啊?啊!好呀,好呀!这个体系架构引领了当时全球广电系统的硬件平台,包括美国的CISCO、德国的Blankom等众多公司以及中国公司都沿用了这个平台架构,成为了全球的事实标准。过去这些技术策略只是在部分领域采用,而在未来需要成为一种具有普遍性的文化和发展战略全面超越美国的基本战略策略,也是中国的优势所在。如果只是补上EUV光刻机与英伟达同级别的人工智能算力芯片,那最多只是与对手打平。只有采用完全不同的赛道,不同的信息技术文化,才能全面实现超越。

以此战略策略为指南,动员了全国的工程技术人员、相关企业、政府人员和投资者,就造成了陷敌于灭顶之灾的汪洋大海,造成了弥补算力芯片、EUV光刻机等等暂时不足的补救条件,造成了克服一切困难并引领未来人类信息技术架构和标准的前提。

本文来自微信公众号:纯科学,作者:纯科学